Projet final

Titre : LLMOSHING

Description : Pouvoir modifier le son donné selon nos envies par le biais du LLM.

Description détaillée : LLM VST AUDIO INSTRUMENT (pas en temps réel, donc synthétiseur (type sampler) et non effet) Pratiquer une forme de data-moshing à l'aide de l'intelligence artificielle qui "trafique" les valeurs données de l'audio pour se rapprocher de ce qu'il pense être le prompt. Ou exécuter des taches précises comme limiter les valeurs négatives à 0. Il travaille la data brute, il ne pense pas "Fréquence, Amplitude..." on peut donc expérimenter, trouver des textures uniques et différentes de n'importe quel VST qui traite l'audio.

Fonctionnement :

-

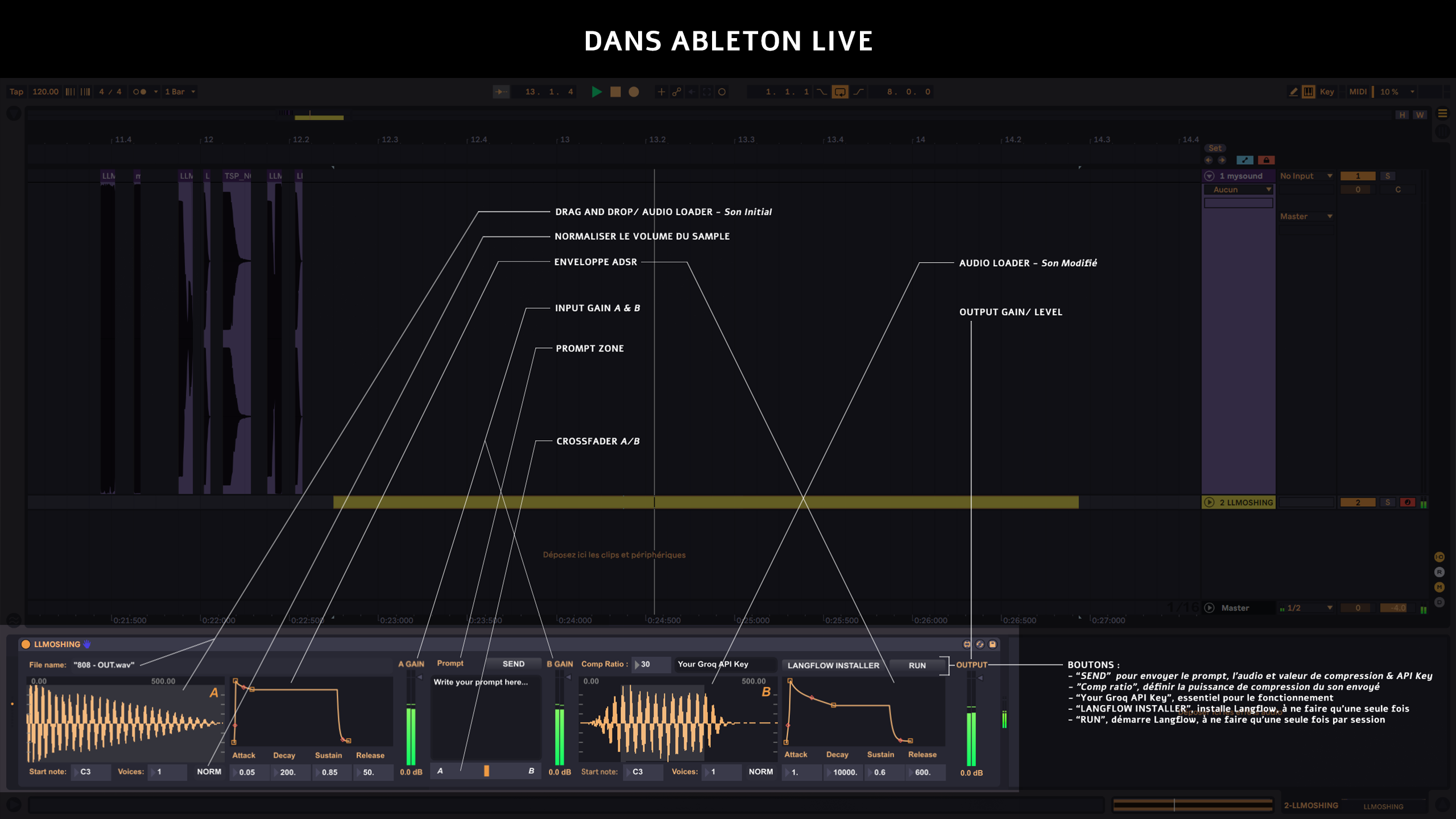

Un VST3, pouvant être ouvert dans Ableton ou Touchdesigner _Avec une interface simple :

- Bouton "Langflow Install", script qui install langflow (à faire une fois)

- Bouton "Langflow Run", script qui lance langflow en arrière plan (à faire une fois par session)

- La zone de drag and drop/ chargement du fichier

- La zone d'écriture texte prompting qui va diriger la manipulation du .wav par le LLM, et son bouton "envoyer"

- Un accès à des post-controls tipique de chaque Sampler : ADSR, VELOCITY, LOOP MOD...

- Gérer le volume d'entrée et de sortie

- Un zone texte pour spécifier où il doit enregistrer le "son modifié", exemple : C:/Desktop

- Un crossfader entre le "son initial" et le "son modifié", permettant de blend et/ou layer les deux sources et de doser l'intensité de chacun _

-

Drag and Drop/ ouvrir un fichier .mp3, .wav ou .flac, sur une surface de survol/ interactive Charge seulement le fichier

-

Gérer volume d'entré du son initial, avec un slider classique le "son initial" devient "son chargé"

-

Prompting, écrire un prompt dans une zone texte

-

Bouton "Send" ou "Envoyer", qui envoie au compileur IA Quand appuyer alors :

- Envoyer l'audio "chargé"

- Envoyer le path du "son modifié", qui spécifie où enregistrer le son

- Envoyer le prompt

-

Compilation IA dans Langflow :

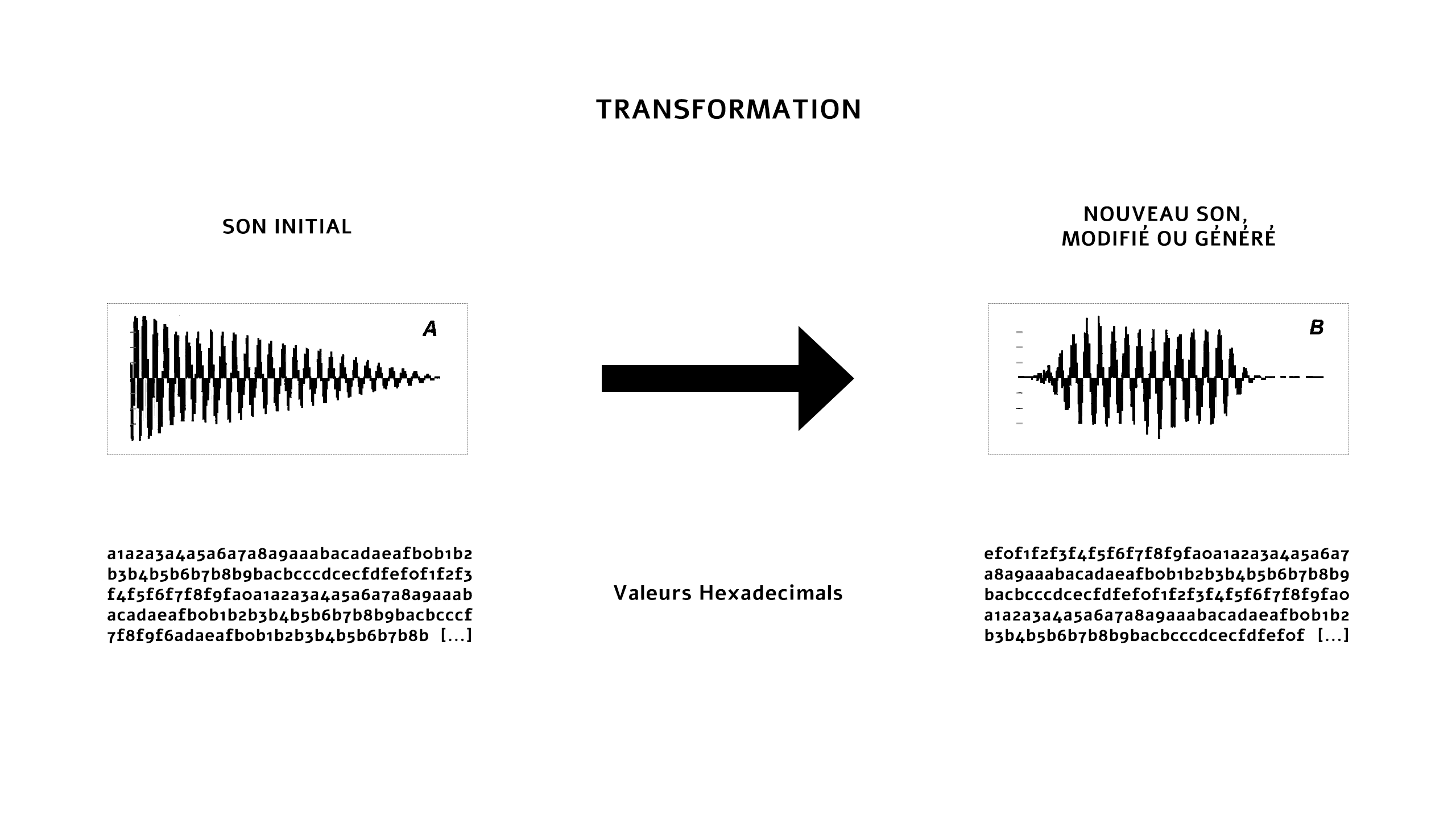

- Le "son modifié" est converti en hexadecimal seulement

- Le son et le texte prompt entre dans le modèle IA Grog : model LLama3-8b-8192, avec un system prompt qui lui spécifie le cadre et lui demandant de sortir uniquement le son modifié en hexadecimal

- Le texte sortant rentre dans un composant .wav encodeur, transformant l'hexadecimal en .wav en rajoutant le formatage, puis exporte le .wav "AIMOSHING_OUT.wav" à l'endroit spécifié, exemple : C:/Desktop/AIMOSHING_OUT.wav

-

Charge le "son modifié" à la fin du processus de compilation, en ouvrant C:/Desktop/AIMOSHING_OUT.wav

-

Toujours la possibilité de jouer de l'instrument / synthèse sonore entre le "son chargé" et le "son modifié" s'il existe (en contrôlant le crossfader A vers B) et en jouant avec une enveloppe ADSR ou une LOOP pour jouer un son sans fin.

- Entré MIDI / KEYS et traitement audio de l'enveloppe et boucle

- Sortie Audio avec le contrôle du volume avec un simple slider (+6db to -infdb)

Présentation :

Quel objet final ?

Une interface intéractive où l'utilisateur choisis un sample audio, écrit un prompt en langage naturel et l'envoie au LLM caché dans le cœur, puis quelque secondes plus tard, un nouveau son jailli. L'utilisateur peut alors désormais jouer le son sur son piano-contrôleur ou simplement récupérer le fichier audio pour encore le "trafiquer". Cela aura la forme d'un plug-in ou VST (instrument virtuel) ouvrable dans n'importe quel DAW (ableton, FL, cubase...). Un sampleur audio classique à la surface, mais un transformateur audio dans le coeur.

Que fait-il ?

Générer/ transformer de l'audio, qui sera matière à un sound-design. Ce n'est pas de la création musical mais réellement de la manipulation sonore et de données. Cela servirait à créer des grains uniques, des textures mathématiques ou simplement du data-moshing-audio. Et viendrait nourrir mes ambiances et productions sonores par des sons percussifs, des glitchs mais surtout des "ear-candies", ces petits détails qui font toute l'originalité d'un son, d'une boucle de batterie ou même d'une musique.

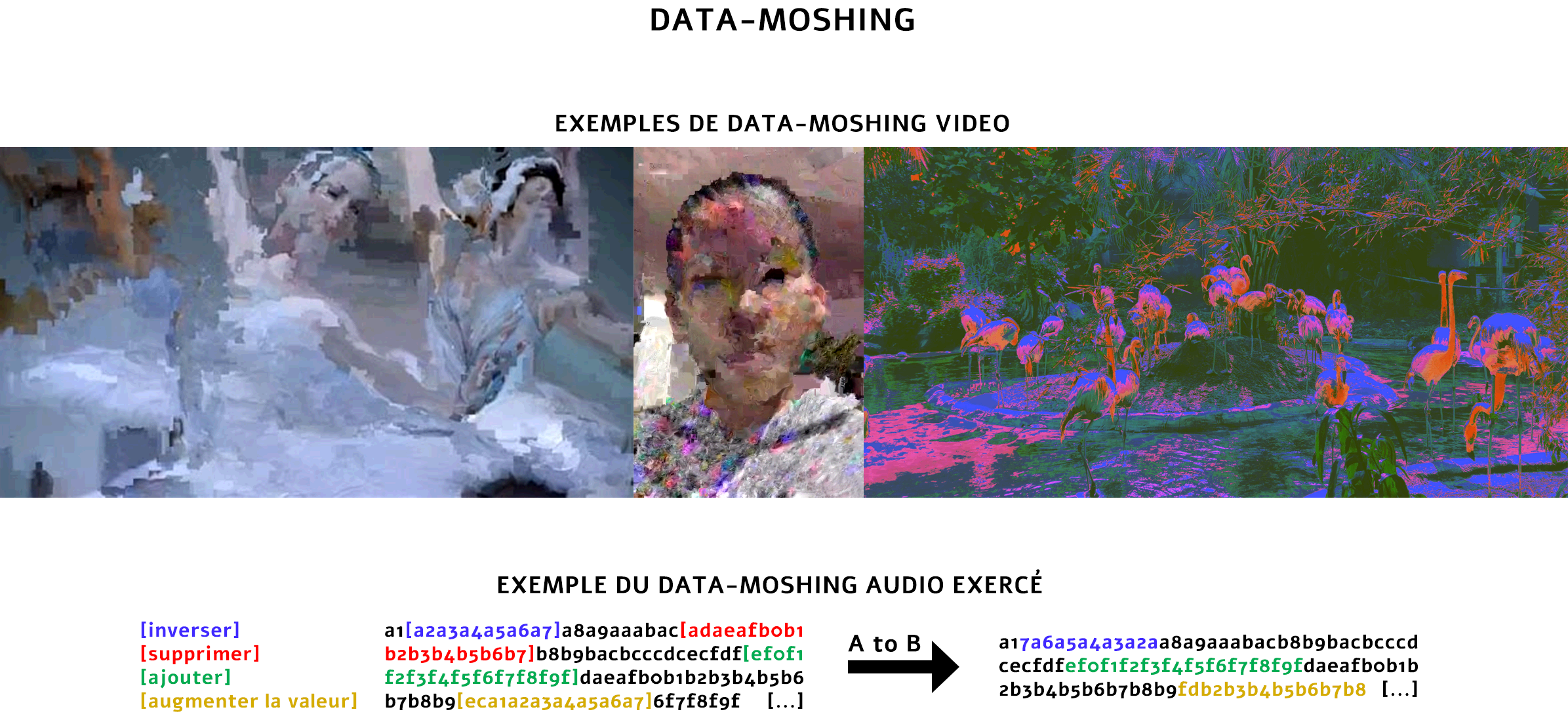

Data-moshing ?

Le data-moshing, c'est comme une danse chaotique entre les pixels et les données, où les images et les sons se déforment et s'entrechoquent sous l'effet d'un glitch maîtrisé. En manipulant les fichiers vidéo ou audio à l'échelle binaire, on crée des transitions où le temps et l'espace se mélangent, donnant naissance à des effets visuels et sonores où la réalité semble se décomposer et se recomposer en fragments numériques hypnotiques. C'est l'art de l'erreur numérique, où l’imperfection devient esthétique. Plus simplement, le data-moshing est une façon de manipuler les données brutes d'un fichier pour en obtenir un autre.

Et ensuite ?

C'est avant tout un outil pour ma pratique et mes projets personnels comme un concept-album sur la thématique des cicatrices. Mais je pense que ça pourrait être à l'avenir un outil de création audio original qui intéresserai les explorateurs du son et Sound-designer cherchant à s'emparer de la sérendipité et de la méthode de modification brute et alternative. "Brute et alternative" car c'est un outil qui prend un contre-pied gigantesque aux normes de la manipulation et modification audio, car il agit sans prendre en compte l'amplitude et les fréquences comme le font la totalité des effets et synthétiseurs audio. Mais cet outil prend seulement en compte l'état global du son et de ce qu'il contient, ce qui fait de lui un matériel intéressant à exploiter pour se détacher des formes que l'on connait touste dans la création sonore.

Je continuerai ce projet mais sans priorité.